健康知识图谱

“The world is not made of strings , but is made of things.” 大千世界,万物相联。保险领域的知识图谱之路,该如何构建?本文将为你介绍健康知识图谱构建流程、整体框架和遇到的问题,并总结健康知识图谱在保险理赔领域应用场景和对应设计。

随着互联网和AI智能的发展,近年来我国的健康险业务迎来了飞速发展和变革。健康险,即健康保险,是保险业务的一个重要分支,有着广阔的发展前景,是本财年保险领域排兵布阵的重要战场。健康险是以被保险人的身体为保险标的,依据合同约定当被保险人遭遇疾病或意外伤害时,对被保险人的医疗费用或财产损失进行补偿或给付的一种保险。

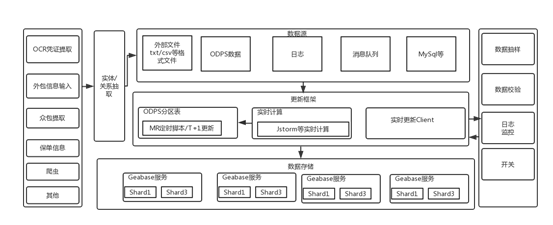

为了支撑日益剧增的理赔单量的挑战,在不增加客服小二工作量的前提下,健康险理赔需要做到智能化、自动化和低风险化。因此,理赔天平团队在智能理赔、理赔机器智能问答和反骗赔等方面做出了相应尝试,而是以上各种尝试所依赖的底层基础技术。

健康知识图谱和Schema示例

健康知识图谱样例如图1所示,其中存储着用户、险种、疾病、医院等各类节点信息以及它们之间的关联信息。比如,用户张三投保了门诊保险金,当 ...

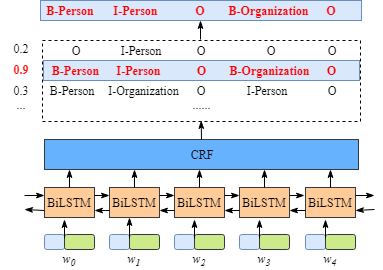

BiLSTM-CRF模型中CRF层的运行原理(4)

前面我们重点介绍了CRF的原理,损失函数以及分数的计算。本节将结合前面的相关内容,介绍基于PyTorch(1.0)框架实现BILSTM-CRF模型及一些需要注意的细节。

模型总览

整个模型结构如下所示,我们也将按照该结构进行实现代码。

由上图可知,整个BILSTM-CRF模型由BILSTM、CRF、损失函数和预测函数几部分组成。BILSTM的输出作为CRF的输入,损失函数定义在CRF中, 损失函数使用前向算法,预测函数使用Viterbi算法,下面逐一介绍。

1234567891011121314151617181920212223242526272829303132333435class BILSTM_CRF(nn.Module): def __init__(self, vocab_size, word_embedding_dim, word2id, hidden_size, bi_flag, num_layer, i ...

kaggle: Plant Seedlings Classification

kaggle上的比赛,从作物幼苗中区分出杂草,有效的解决方案意味着更好的作物产量及更好的环境管理。

奥胡斯大学信号处理组与丹麦南方大学合作,发布了一个数据集,其中包含不同生长阶段的 12 个种类大约 960 种植物的图像 ,

数据集下载地址:https://www.kaggle.com/c/plant-seedlings-classification

上述图像数据已公开发布。它包含带注释的 RGB 图像,分辨率约为每毫米 10 个像素。

采用基于 F1 分数的指标对分类结果进行评估。以下图像是描述数据集中所有 12 个类的示例:

我们主要按照一下5步骤完成图片分类任务:

step 1

机器学习的首要任务是分析数据集,然后进行算法实验。了解数据集的复杂性,这一步很重要,这最终将有助于算法的设计。

该数据的标签分布如下:

如上所述,该数据集包含 12 个类共 4750 个图像。但是,从上图可以看出,各类分布不平均,最大 个数为654 张,而最小个数为 221 张。下图清楚地表明数据是不平均的,因此,为了获得更好的结果,我们需要对原始数据进行类平衡处理。step 3 中我们将完成此任 ...

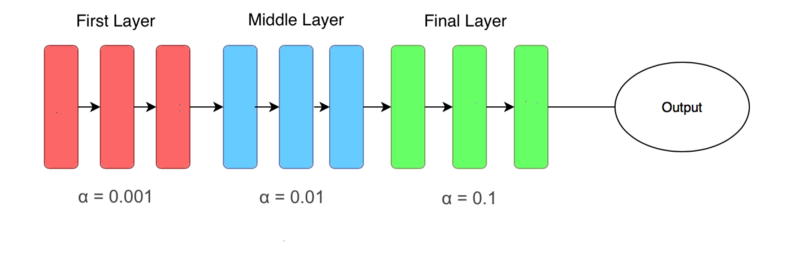

Kaggle的十大深度学习技巧

在各种Kaggle竞赛的排行榜上,都有不少刚刚进入深度学习领域的程序员,其中大部分有一个共同点:

都上过Fast.ai的课程。

这些免费、重实战的课程非常鼓励学生去参加Kaggle竞赛,检验自己的能力。当然,也向学生们传授了不少称霸Kaggle的深度学习技巧。

是什么秘诀让新手们在短期内快速掌握并能构建最先进的DL算法?一位名叫塞缪尔(Samuel Lynn-Evans)的法国学员总结了十条经验。

他这篇文章发表在FloydHub官方博客上,因为除了来自Fast.ai的技巧之外,他还用了FloydHub的免设置深度学习GPU云平台。

接下来,我们看看他从fast.ai学来的十大技艺:

1. 使用Fast.ai库

这一条最为简单直接。

1from fast.ai import *

Fast.ai库是一个新手友好型的深度学习工具箱,而且是目前复现最新算法的首要之选。

每当Fast.ai团队及AI研究者发现一篇有趣论文时,会在各种数据集上进行测试,并确定合适的调优方法。他们会把效果较好的模型实现加入到这个函数库中,用户可以快速载入这些模型。

于是,Fast.ai库成了一个功能强大的工具箱 ...

BiLSTM模型中CRF层的运行原理(3)

在前面的部分中,我们学习了BiLSTM-CRF模型的结构和CRF损失函数的细节。您可以通过各种开源框架(Keras,Chainer,TensorFlow等)实现您自己的BiLSTM-CRF模型。最重要的事情之一是在这些框架上自动计算模型的反向传播,因此您不需要自己实现反向传播来训练模型(即计算梯度和更新参数)。此外,一些框架已经实现了CRF层,因此只需添加一行代码就可以非常轻松地将CRF层与您自己的模型相结合。

在本节中,我们将探讨如何预测句子的标签序列。

1. 预测句子的标签序列

第1步:BiLSTM-CRF模型的emission score和transition score

假设句子xxx包含3个字符:x=[w0,w1,w2]x=[w_0, w_1, w_2]x=[w0,w1,w2]。此外,假设我们已经获得了BiLSTM模型的emission score和CRF层的transition score:

l1l_1l1

l2l_2l2

w0w_0w0

w01w_{01}w01

w02w_{02}w02

w1w_1w1

w11w_{11}w11

...

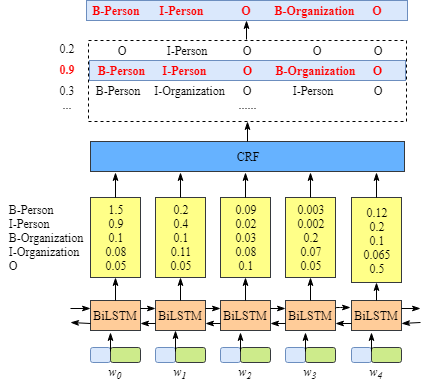

BiLSTM模型中CRF层的运行原理(2)

在上一节中,我们知道CRF层可以从训练数据集中自动学习到一些约束规则来保证预测标签的合法性。这些约束包括:

句子中第一个词总是以标签“B-“ 或 “O”开始,而不是“I-”

标签“B-label1I-label2 I-label3 I-…”,label1, label2, label3应该属于同一类实体。例如,“B-PersonI-Person” 是合理的序列, 但是“B-Person I-Organization” 是不合理标签序列.

标签序列“O I-label”是不合理的,实体标签的首个标签应该是 “B-“ ,而非 “I-“, 换句话说,有效的标签序列应该是“O B-label”。

这一节,我们将解释为什么CRF层会自动学习到这些约束规则。

1.CRF层

在CRF层损失函数中,有两种形式的score。这些scores是CRF层的关键概念。

1.1 emission score

第一个是emission score,主要来自BiLSTM层的输出,如下图所示,比如,单元w0w_0w0标记为‘B-Person’的score为1.5:

为了方便起见,我们用数字来表示各个实体标签 ...

Adversarial validation

之前参加了kaggle的Toxic比赛,名次为Top1%(瞎打,忙于项目——提不上去的理由了,安慰自己)。回头看别人分享的kernel时,发现了Adversarial validation,本文也是直接copy fastml以及来自kaggle中一个kernel。

在比赛中,可能会遇到测试数据集与训练数据集分布明显不同。这时候,我们常用的k-折交叉验证可能达不到想要的效果,即训练集上的交叉验证结果可能与测试集上的结果相差甚远。

可能是由以下原因造成:

1.过细的学习训练数据集,即可能也把噪声数据学习到了。

2.训练数据集和测试数据集存在显著差异,即分布不同。

问题

对于第一个问题,我们可以使用一些正则化手段解决过拟合问题,那么对于第二个问题,我们该如何解决?如果你参加过像Kaggle这样的竞赛,你就会知道这些竞赛的模式。在比赛中,你可以下载到一个train数据集和test数据集。你需要在train数据上训练你的模型,在test数据上预测并且在上传到Kaggle平台上来得到你排名。

我们通常做法是将完整的train数据集划分为train和valid数据集。valid数据用于评估与模 ...

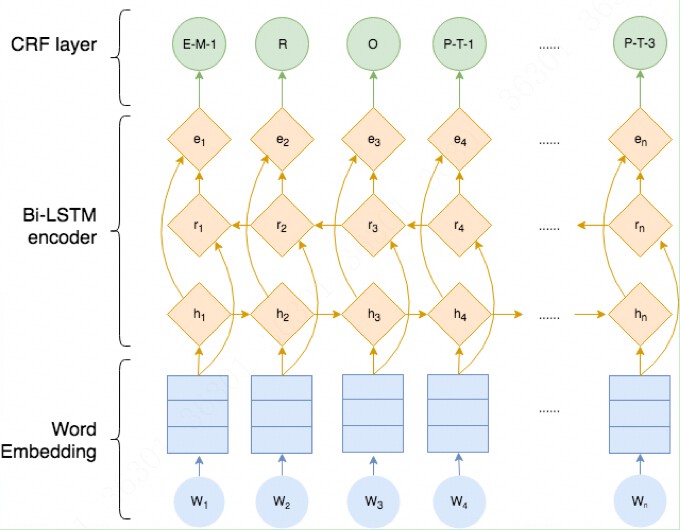

BiLSTM模型中CRF层的运行原理(1)

本文主要内容如下:

介绍: 在命名实体识别任务中,BiLSTM模型中CRF层的通用思想

实例: 通过实例来一步步展示CRF的工作原理

实现: CRF层的一步步实现过程

备注: 需要有的基础知识:你只需要知道什么是命名实体识别,如果你不懂神经网络,条件随机场(CRF)或者其它相关知识,不必担心,本文将向你展示CRF层是如何工作的。本文将尽可能的讲的通俗易懂。

1.介绍

基于神经网络的方法,在命名实体识别任务中非常流行和普遍。在文献[1]中,作者提出了BiLSTM-CRF模型用于实体识别任务中,在模型中用到了字嵌入和词嵌入。本文将向你展示CRF层是如何工作的。

如果你不知道BiLSTM和CRF是什么,你只需要记住他们分别是命名实体识别模型中的两个层。

1.1开始之前

我们假设我们的数据集中有两类实体——人名和地名,与之相对应在我们的训练数据集中,有五类标签:

B-Person

I-Person

B-Organization

I-Organization

O

假设句子xxx由5个字符组成,即x=(w0,w1,w2,w3,w4)x = (w_0,w_1,w_2,w_3,w_4)x=( ...

使用交叉验证提高模型预测能力

交叉验证是一种用来衡量和评估机器学习模型性能的技术,在模型训练过程,我们创建了训练集的多个分区,并在这些分区的不同子集上进行训练/测试。

本文我们主要介绍不同的交叉验证方法。

交叉验证经常用于给定的数据集训练、评估和最终选择机器学习模型,因为它有助于评估模型的结果在实践中如何推广到独立的数据集,最重要的是,交叉验证已经被证明产生比其他方法更低的偏差的模型。

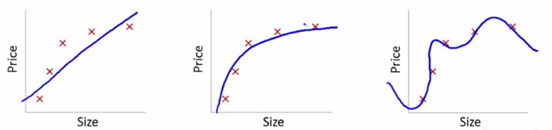

模型无法保持稳定?

让我们通过以下几幅图来理解这个问题:

此处,我们试图找到size和price的关系,三个模型各自做了如下工作:

1.第一个模型使用了线性等式。对于训练数据集,该模型存在很大的误差。这样的模型效果往往不太好,这是欠拟合的一个例子。此模型不足以发掘数据背后的趋势。

2.第二个模型发现了price和size的正确关系,此模型误差低,拟合关系较强。

3.第三个模型对于训练数据集而言几乎是零误差。这是因为此模型把每一个数据点的偏差(包括噪声)都纳入了考虑的范围,也就是说,这个模型太过敏感了,甚至会捕抓到在当前训练数据集出现的一些随机模式。这是“过拟合”的一个例子,这个模型往往会造成在训练效果很好而在测试效果很差。

...

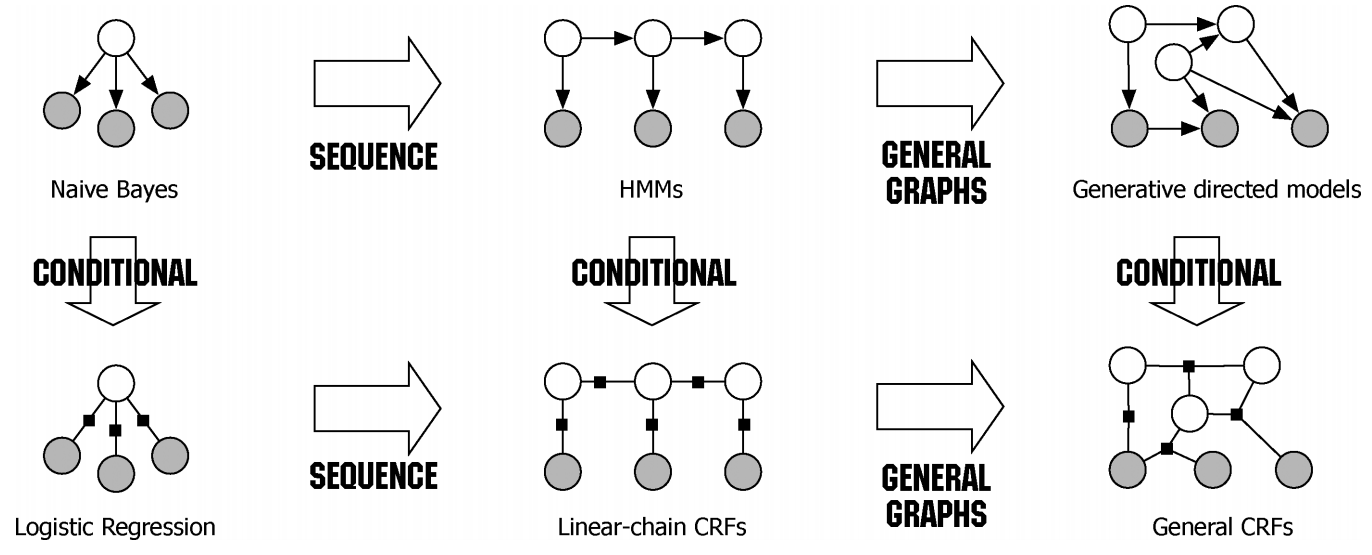

条件随机场-CRF

最近一段时间在研究NER相关项目,因此,打算对NER一些算法做一定总结,本文主要记录自己在学习CRF模型过程中的一些记录,大部分来自于网上各位大神的博客。

什么样的问题需要CRF模型

假设你有许多小明同学一天内不同时段的照片,从小明提裤子起床到脱裤子睡觉各个时间段都有(小明是照片控!)。现在的任务是对这些照片进行分类。比如有的照片是吃饭,那就给它打上吃饭的标签;有的照片是跑步时拍的,那就打上跑步的标签;有的照片是开会时拍的,那就打上开会的标签。问题来了,你准备怎么干?

一个简单直观的办法就是,不管这些照片之间的时间顺序,想办法训练出一个多元分类器。就是用一些打好标签的照片作为训练数据,训练出一个模型,直接根据照片的特征来分类。例如,如果照片是早上6:00拍的,且画面是黑暗的,那就给它打上睡觉的标签;如果照片上有车,那就给它打上开车的标签。

这样可行吗?

乍一看可以!但实际上,由于我们忽略了这些照片之间的时间顺序这一重要信息,我们的分类器会有缺陷的。举个例子,假如有一张小明闭着嘴的照片,怎么分类?显然难以直接判断,需要参考闭嘴之前的照片,如果之前的照片显示小明在吃饭,那这个闭嘴的照片很 ...