2025-03|高质量中文预训练模型集合

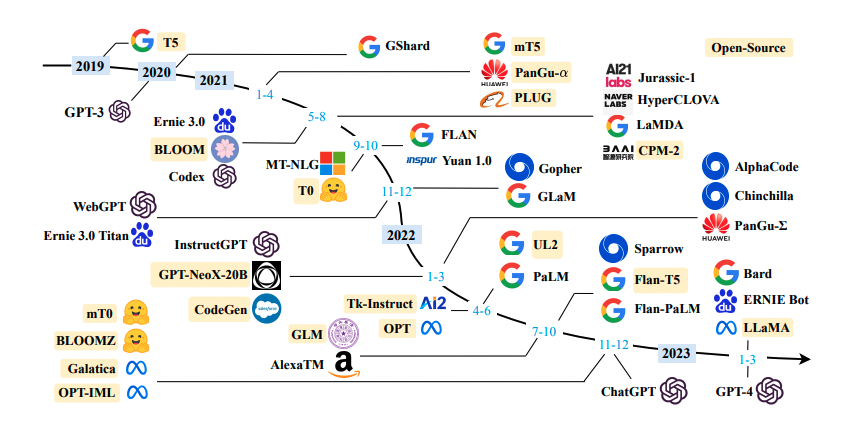

在自然语言处理领域中,预训练语言模型(Pretrained Language Models)已成为非常重要的基础技术,本仓库主要收集目前网上公开的一些高质量中文预训练模型(感谢分享资源的大佬),并将持续更新…

最新的模型汇总地址github: https://github.com/lonePatient/awesome-pretrained-chinese-nlp-models

Expand Table of Contents

更新日志

基础大模型

对话大模型

多模态对话大模型

大模型评估基准

在线体验大模型

开源模型库平台

开源数据集库

开源中文指令数据集

Other-Awesome

NLU系列

BERT

RoBERTa

ALBERT

NEZHA

XLNET

MacBERT

WoBERT

ELECTRA

ZEN

ERNIE

ERNIE3

RoFormer

StructBERT

Lattice-BERT

Mengzi-BERT

ChineseBERT

TaCL

MC-BERT

二郎神

PERT

MobileBERT

GAU-α

DeBE ...

Arxiv今日论文 | 2026-03-10

本篇博文主要内容为 2026-03-10 从Arxiv.org论文网站获取的最新论文列表,自动更新,按照NLP、CV、ML、AI、IR、MA六个大方向区分。

说明:每日论文数据从Arxiv.org获取,每天早上12:30左右定时自动更新。

提示: 当天未及时更新,有可能是Arxiv当日未有新的论文发布,也有可能是脚本出错。尽可能会在当天修复。

目录

概览

自然语言处理CL

多智能体系统MA

信息检索IR

人机交互HC

人工智能AI

机器学习LG

计算机视觉CV

概览 (2026-03-10)

今日共更新750篇论文,其中:

自然语言处理共91篇(Computation and Language (cs.CL))

人工智能共192篇(Artificial Intelligence (cs.AI))

计算机视觉共201篇(Computer Vision and Pattern Recognition (cs.CV))

机器学习共194篇(Machine Learning (cs.LG))

多智能体系统共4篇(Multiagent Systems (cs.MA))

信息检索共17篇 ...

Arxiv今日论文 | 2026-03-09

本篇博文主要内容为 2026-03-09 从Arxiv.org论文网站获取的最新论文列表,自动更新,按照NLP、CV、ML、AI、IR、MA六个大方向区分。

说明:每日论文数据从Arxiv.org获取,每天早上12:30左右定时自动更新。

提示: 当天未及时更新,有可能是Arxiv当日未有新的论文发布,也有可能是脚本出错。尽可能会在当天修复。

目录

概览

自然语言处理CL

多智能体系统MA

信息检索IR

人机交互HC

人工智能AI

机器学习LG

计算机视觉CV

概览 (2026-03-09)

今日共更新548篇论文,其中:

自然语言处理共70篇(Computation and Language (cs.CL))

人工智能共148篇(Artificial Intelligence (cs.AI))

计算机视觉共175篇(Computer Vision and Pattern Recognition (cs.CV))

机器学习共127篇(Machine Learning (cs.LG))

多智能体系统共8篇(Multiagent Systems (cs.MA))

信息检索共11篇 ...

Arxiv今日论文 | 2026-03-06

本篇博文主要内容为 2026-03-06 从Arxiv.org论文网站获取的最新论文列表,自动更新,按照NLP、CV、ML、AI、IR、MA六个大方向区分。

说明:每日论文数据从Arxiv.org获取,每天早上12:30左右定时自动更新。

提示: 当天未及时更新,有可能是Arxiv当日未有新的论文发布,也有可能是脚本出错。尽可能会在当天修复。

目录

概览

自然语言处理CL

多智能体系统MA

信息检索IR

人机交互HC

人工智能AI

机器学习LG

计算机视觉CV

概览 (2026-03-06)

今日共更新631篇论文,其中:

自然语言处理共116篇(Computation and Language (cs.CL))

人工智能共212篇(Artificial Intelligence (cs.AI))

计算机视觉共113篇(Computer Vision and Pattern Recognition (cs.CV))

机器学习共177篇(Machine Learning (cs.LG))

多智能体系统共17篇(Multiagent Systems (cs.MA))

信息检索共1 ...

Arxiv今日论文 | 2026-03-05

本篇博文主要内容为 2026-03-05 从Arxiv.org论文网站获取的最新论文列表,自动更新,按照NLP、CV、ML、AI、IR、MA六个大方向区分。

说明:每日论文数据从Arxiv.org获取,每天早上12:30左右定时自动更新。

提示: 当天未及时更新,有可能是Arxiv当日未有新的论文发布,也有可能是脚本出错。尽可能会在当天修复。

目录

概览

自然语言处理CL

多智能体系统MA

信息检索IR

人机交互HC

人工智能AI

机器学习LG

计算机视觉CV

概览 (2026-03-05)

今日共更新591篇论文,其中:

自然语言处理共105篇(Computation and Language (cs.CL))

人工智能共211篇(Artificial Intelligence (cs.AI))

计算机视觉共135篇(Computer Vision and Pattern Recognition (cs.CV))

机器学习共174篇(Machine Learning (cs.LG))

多智能体系统共10篇(Multiagent Systems (cs.MA))

信息检索共1 ...

Arxiv今日论文 | 2026-03-04

本篇博文主要内容为 2026-03-04 从Arxiv.org论文网站获取的最新论文列表,自动更新,按照NLP、CV、ML、AI、IR、MA六个大方向区分。

说明:每日论文数据从Arxiv.org获取,每天早上12:30左右定时自动更新。

提示: 当天未及时更新,有可能是Arxiv当日未有新的论文发布,也有可能是脚本出错。尽可能会在当天修复。

目录

概览

自然语言处理CL

多智能体系统MA

信息检索IR

人机交互HC

人工智能AI

机器学习LG

计算机视觉CV

概览 (2026-03-04)

今日共更新597篇论文,其中:

自然语言处理共63篇(Computation and Language (cs.CL))

人工智能共188篇(Artificial Intelligence (cs.AI))

计算机视觉共136篇(Computer Vision and Pattern Recognition (cs.CV))

机器学习共193篇(Machine Learning (cs.LG))

多智能体系统共8篇(Multiagent Systems (cs.MA))

信息检索共14篇 ...

Arxiv今日论文 | 2026-03-03

本篇博文主要内容为 2026-03-03 从Arxiv.org论文网站获取的最新论文列表,自动更新,按照NLP、CV、ML、AI、IR、MA六个大方向区分。

说明:每日论文数据从Arxiv.org获取,每天早上12:30左右定时自动更新。

提示: 当天未及时更新,有可能是Arxiv当日未有新的论文发布,也有可能是脚本出错。尽可能会在当天修复。

目录

概览

自然语言处理CL

多智能体系统MA

信息检索IR

人机交互HC

人工智能AI

机器学习LG

计算机视觉CV

概览 (2026-03-03)

今日共更新934篇论文,其中:

自然语言处理共125篇(Computation and Language (cs.CL))

人工智能共318篇(Artificial Intelligence (cs.AI))

计算机视觉共256篇(Computer Vision and Pattern Recognition (cs.CV))

机器学习共250篇(Machine Learning (cs.LG))

多智能体系统共16篇(Multiagent Systems (cs.MA))

信息检索共2 ...

Arxiv今日论文 | 2026-03-02

本篇博文主要内容为 2026-03-02 从Arxiv.org论文网站获取的最新论文列表,自动更新,按照NLP、CV、ML、AI、IR、MA六个大方向区分。

说明:每日论文数据从Arxiv.org获取,每天早上12:30左右定时自动更新。

提示: 当天未及时更新,有可能是Arxiv当日未有新的论文发布,也有可能是脚本出错。尽可能会在当天修复。

目录

概览

自然语言处理CL

多智能体系统MA

信息检索IR

人机交互HC

人工智能AI

机器学习LG

计算机视觉CV

概览 (2026-03-02)

今日共更新497篇论文,其中:

自然语言处理共59篇(Computation and Language (cs.CL))

人工智能共136篇(Artificial Intelligence (cs.AI))

计算机视觉共123篇(Computer Vision and Pattern Recognition (cs.CV))

机器学习共139篇(Machine Learning (cs.LG))

多智能体系统共8篇(Multiagent Systems (cs.MA))

信息检索共33篇 ...

Arxiv今日论文 | 2026-02-27

本篇博文主要内容为 2026-02-27 从Arxiv.org论文网站获取的最新论文列表,自动更新,按照NLP、CV、ML、AI、IR、MA六个大方向区分。

说明:每日论文数据从Arxiv.org获取,每天早上12:30左右定时自动更新。

提示: 当天未及时更新,有可能是Arxiv当日未有新的论文发布,也有可能是脚本出错。尽可能会在当天修复。

目录

概览

自然语言处理CL

多智能体系统MA

信息检索IR

人机交互HC

人工智能AI

机器学习LG

计算机视觉CV

概览 (2026-02-27)

今日共更新644篇论文,其中:

自然语言处理共82篇(Computation and Language (cs.CL))

人工智能共215篇(Artificial Intelligence (cs.AI))

计算机视觉共139篇(Computer Vision and Pattern Recognition (cs.CV))

机器学习共206篇(Machine Learning (cs.LG))

多智能体系统共9篇(Multiagent Systems (cs.MA))

信息检索共35篇 ...

Arxiv今日论文 | 2026-02-26

本篇博文主要内容为 2026-02-26 从Arxiv.org论文网站获取的最新论文列表,自动更新,按照NLP、CV、ML、AI、IR、MA六个大方向区分。

说明:每日论文数据从Arxiv.org获取,每天早上12:30左右定时自动更新。

提示: 当天未及时更新,有可能是Arxiv当日未有新的论文发布,也有可能是脚本出错。尽可能会在当天修复。

目录

概览

自然语言处理CL

多智能体系统MA

信息检索IR

人机交互HC

人工智能AI

机器学习LG

计算机视觉CV

概览 (2026-02-26)

今日共更新517篇论文,其中:

自然语言处理共77篇(Computation and Language (cs.CL))

人工智能共113篇(Artificial Intelligence (cs.AI))

计算机视觉共123篇(Computer Vision and Pattern Recognition (cs.CV))

机器学习共151篇(Machine Learning (cs.LG))

多智能体系统共10篇(Multiagent Systems (cs.MA))

信息检索共15 ...