cw2vec Learning Chinese Word Embeddings with Stroke n-gram Information

cw2vec是蚂蚁金服2018年提出的基于笔画的中文词的embedding 方法。文中作者提到利用笔画级别的信息对于改进中文词语嵌入的学习至关重要。具体来说,首先将词转化为笔画序列,然后通过对笔画序列进行n-gram来捕获中文单词的语义和形态信息。

实现的代码地址: https://github.com/lonePatient/cw2vec-pytorch

1.介绍

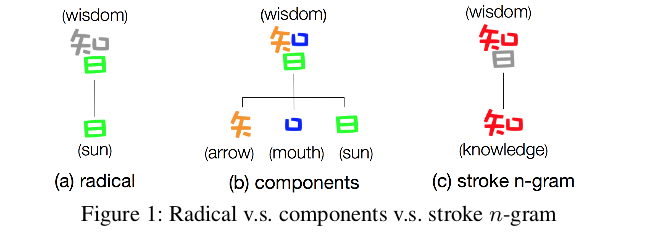

我们知道,在中文中,每个单词的字符个数往往比英文单词少,每个字符包含了丰富的语义信息。但是字符级的信息足以恰当地捕捉单词的语义信息吗?是否还有其他有用的信息可以从单词和字符中提取出来,以更好地捕抓单词的语义?例如,两个单词“木材”和“森林”在语义上紧密相关。然而,“木材”由“木”和材”两个字符组成,而“森林”由“森”和“林 ”两个字符组成。如果仅考虑字符级信息,很显然该两个单词由不同的字符组成,那么在这两个单词之间是没有共享的信息。另外,如图1(a)所示,“日”作为“智”的一部分,但是几乎不包含与"智"相关的任何语义信息。除了传统的偏旁部首,再来看看另一种形式,如图1(b)所示,“智”被分解为“矢”, ...

PyTorch常用代码段

记录一些常用的Pytorch代码,方便后续查找。

编码风格

我们试图遵循 Google 的 Python 编程风格。请参阅 Google 提供的优秀的 python 编码风格指南(见参考资料)。

在这里,我们会给出一个最常用命名规范小结:

Type

Convention

Example

Packages & Modules

lower_with_under

from prefetch_generator import BackgroundGenerator

Classes

CapWords

class DataLoader

Constants

CAPS_WITH_UNDER

BATCH_SIZE=16

Instances

lower_with_under

dataset = Dataset

Methods & Functions

lower_with_under()

def visualize_tensor()

Variables

lower_with_under

background_color=‘Blue’

常用模块

常用的 ...

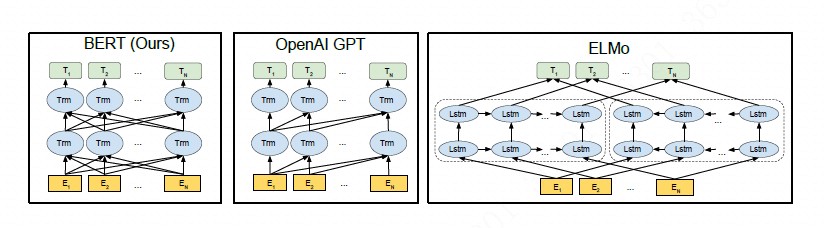

BERT-Pre-training of Deep Bidirectional Transformers for Language Understanding

本文介绍一种新的语言表征模型BERT—基于Transformers的双向编码器表示。异于最新语言表征模型,BERT基于所有层的左、右语境来预训练深度双向表征。BERT是首个大批句子层面和词块层面任务中取得当前最优性能的表征模型,性能超越许多使用任务特定架构的系统,刷新11项NLP任务当前最优性能记录,堪称最强NLP预训练模型!未来可能成为新行业基础。本文参考网上各大文章,整理翻译了BERT论文,在自己学习的同时也分享给大家,欢迎交流指教。

摘要

本文介绍一种称之为BERT的新语言表征模型,即Transformers的双向编码器表征量(BidirectionalEncoder Representations from Transformers)。不同于最近的语言表征模型(Peters等,2018; Radford等,2018),BERT旨在基于所有层的左、右语境来预训练深度双向表征。因此,预训练的BERT表征可以仅用一个额外的输出层进行微调,进而为很多任务(如问答和语言推理)创建当前最优模型,无需对任务特定架构做出大量修改。

BERT的概念很简单,但实验效果很强大。它刷新了11个NLP ...

Pytorch深度学习入门

在本教程中,将使用Pytorch框架介绍深度学习,并通过一个简单案例进行实验,通过本教程,你将可以轻松地使用Pytorch框架构建深度学习模型。(我也刚刚接触Pytorch)

Pytorch 简介

Pytorch 是一个基于 Torch 的 Python 机器学习包,而 Torch 则是一个基于编程语言 Lua 的开源机器学习包。Pytorch 有两个主要的特点:

利用强大的 GPU 加速进行张量计算(如 NumPy)

用于构建和训练神经网络的自动微分机制

相比其它深度学习库,Pytorch 具有以下两点优势:

与 TensorFlow 等其它在运行模型之前必须先定义整个计算图的库不同,Pytorch 允许动态定义图。

Pytorch 也非常适合深度学习研究,提供了最大的灵活性和运行速度。

Tensors

Pytorch 张量与 NumPy 数组非常相似,而且它们可以在 GPU 上运行。这一点很重要,因为它有助于加速数值计算,从而可以将神经网络的速度提高 50 倍甚至更多。为了使用 Pytorch,你需要先访问其官网并安装 Pytorch。如果你正在使用 Conda,你可以通 ...

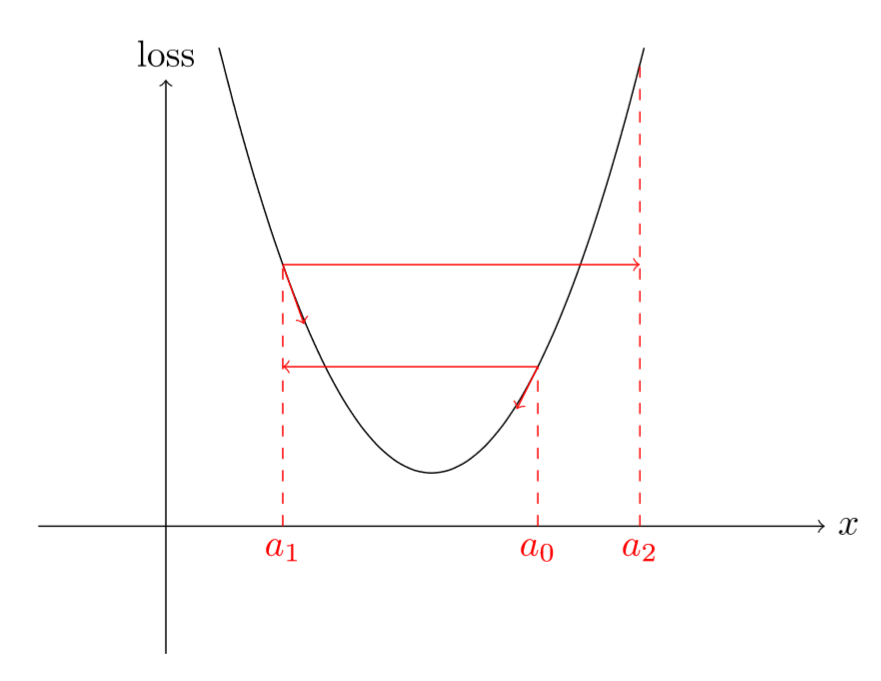

如何找到一个好的学习率

我们知道学习率是深度学习模型中一个非常重要的超参数,因此,当训练深度学习模型时,我们如何确定学习率的大小? 如果学习率太小,网络将会训练很慢且耗时(比如学习率设置为1e-6)。如果学习率太高,网络在训练过程中可能会跳过最小值点。更糟糕的是,高学习率可能会导致loss不断变大,这样就脱离了模型的学习目标。

介绍

如下图所示,高的学习率,可能会出现跳过最小值点情况,并且loss还增加:

图1

因此,对于训练深度学习模型,我们需要选择一个合理的学习率大小,既不能太大也不能太小。以往我们根据不同的学习率实验或者经验得到一个“认为”合理的学习率,但在在这篇文章中提出了一种新方法: 在一个epoch中,首先,对优化器(比如SGD)设置一个非常低的学习率(如10-8),然后,在每次小batch数据训练中改变学习率(比如乘以某个因子),直到学习率达到一个非常高的值(如1或10)或者loss开始变大,停止训练,最后,我们将学习率和loss变化绘制在同张图中,如下图所示:

图2

仔细观察上图,会发现,一开始loss在减少,但是瞬间停止并且变大,这个主要是因为学习率非常低。但是,随着学习率的变大,lo ...

周期性学习率(Cyclical Learning Rate)技术

本文介绍神经网络训练中的周期性学习率技术。

Introduction

学习率(learning_rate, LR)是神经网络训练过程中最重要的超参数之一,它对于快速、高效地训练神经网络至关重要。简单来说,LR决定了我们当前的权重参数朝着降低损失的方向上改变多少。

1new_weight = exsiting_weight - learning_rate * gradient

这看上去很简单。但是正如许多研究显示的那样,单单通过提升这一步就会对我们的训练产生深远的影响,并且尚有很大的优化空间。

本文介绍了一种叫做周期性学习率(CLR)的技术,它是一种非常新的、简单的想法,用来设置和控制训练过程中LR的大小。该技术在jeremyphoward今年的fast.ai course课程中提及过。

Motivation

神经网络用来完成某项任务需要对大量参数进行训练。参数训练意味着寻找合适的一些参数,使得在每个batch训练完成后损失(loss)达到最小。

通常来说,有两种广泛使用的方法用来设置训练过程中的LR。

One LR for all parameters

一个典型的例子是SGD, 在 ...

Dropout在RNN中的应用综述

这篇文章中,提供了Dropout的背景和概述,以及应用于使用LSTM / GRU递归神经网络的语言建模的参数分析。

Dropout

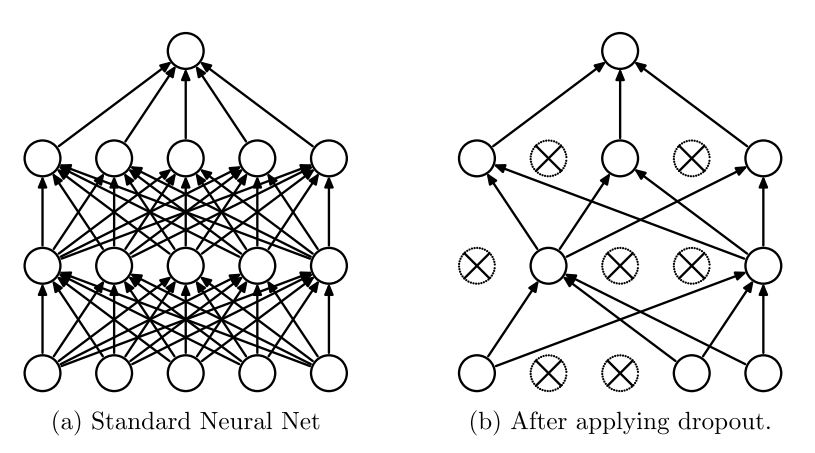

受性别在进化中的作用的启发,Hinton等人最先提出Dropout,即暂时从网络中移除神经网络中的单元。 Srivastava等人将Dropout应用于前馈神经网络和受限玻尔兹曼机,并注意到隐层0.5,输入层0.2的 dropout 率 适用于各种任务。

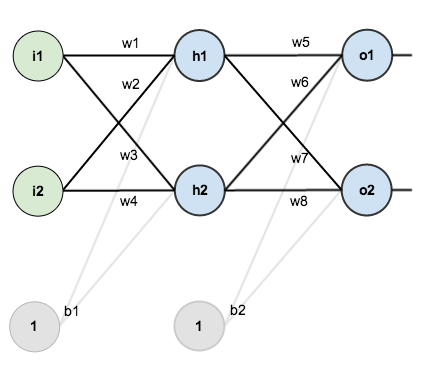

图1. a)标准神经网络,没有dropout。 b)应用了dropout的神经网络。

Srivastava等人的工作的核心概念是“在加入了dropout的神经网络在训练时,每个隐藏单元必须学会随机选择其他单元样本。这理应使每个隐藏的单元更加健壮,并驱使它自己学到有用的特征,而不依赖于其他隐藏的单元来纠正它的错误“。在标准神经网络中,每个参数通过梯度下降逐渐优化达到全局最小值。因此,隐藏单元可能会为了修正其他单元的错误而更新参数。这可能导致“共适应”,反过来会导致过拟合。而假设通过使其他隐藏单元的存在不可靠,dropout阻止了每个隐藏单元的共适应。

对于每个训练样本,重新调整网络并丢弃一组新的神经元 ...

知识抽取-实体及关系抽取

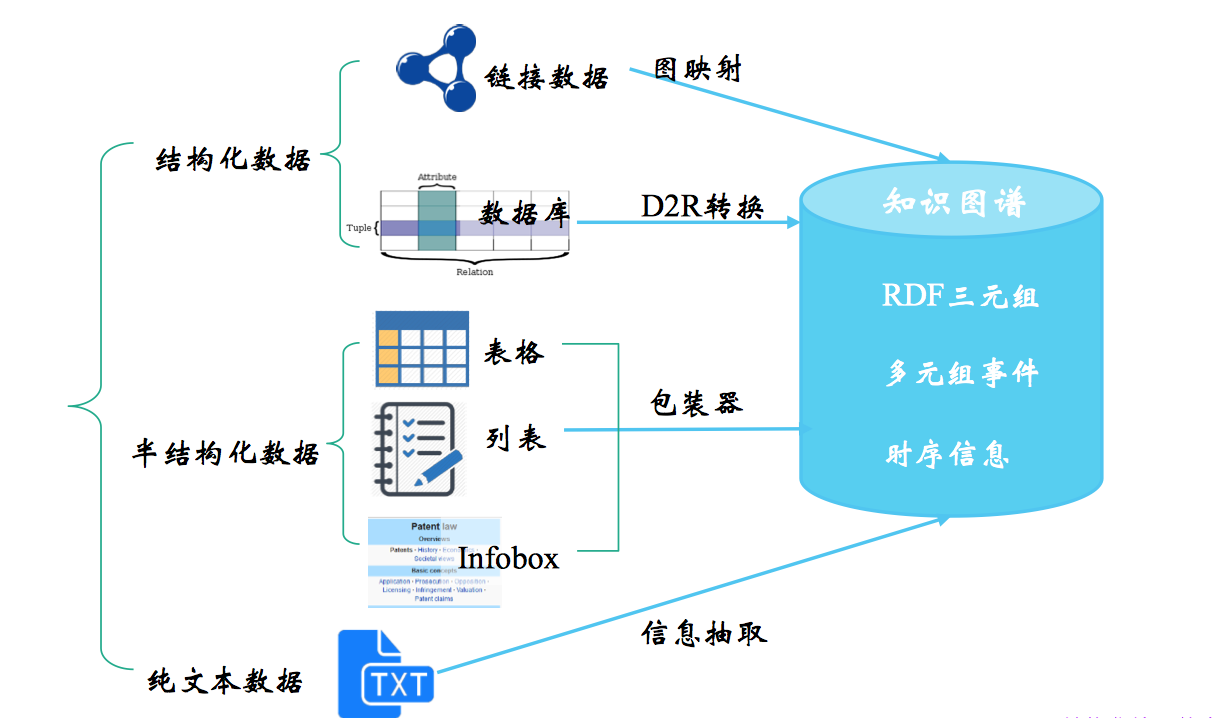

知识抽取涉及的“知识”通常是 清楚的、事实性的信息,这些信息来自不同的来源和结构,而对不同数据源进行的知识抽取的方法各有不同,从结构化数据中获取知识用 D2R,其难点在于复杂表数据的处理,包括嵌套表、多列、外键关联等,从链接数据中获取知识用图映射,难点在于数据对齐,从半结构化数据中获取知识用包装器,难点在于 wrapper 的自动生成、更新和维护,这一篇主要讲从文本中获取知识,也就是我们广义上说的信息抽取。

信息抽取三个最重要/最受关注的子任务:

实体抽取

也就是命名实体识别,包括实体的检测(find)和分类(classify)

关系抽取

通常我们说的三元组(triple) 抽取,一个谓词(predicate)带 2 个形参(argument),如 Founding-location(IBM,New York)

事件抽取

相当于一种多元关系的抽取

篇幅限制,这一篇主要整理实体抽取和关系抽取,下一篇再上事件抽取。

相关竞赛与数据集

信息抽取相关的会议/数据集有 MUC、ACE、KBP、SemEval 等。其中,ACE(Automated Content Extract ...

Kaggle竞赛-Home Credit Risk小结

Kaggle竞赛-Home Credit Default Risk小结

竞赛网址:kaggle home credit default risk

Home Credit

Home Credit(中文: 捷信消费金融有限公司)是中东欧/亚洲的一家消费金融提供商, 为客户提供金融服务.

比赛简介

业务背景

Home Credit希望能通过数据挖掘和机器学习算法来估计客户的贷款违约概率.

数据

(1) application_train/test 客户申请表

包含了目标变量(客户是否违约-0/1变量), 客户申请贷款信息(贷款类型, 贷款总额, 年金), 客户基本信息(性别, 年龄, 家庭, 学历, 职业, 行业, 居住地情况), 客户财务信息(年收入, 房/车情况), 申请时提供的资料等.

(2) bureau/bureau_balance 由其他金融机构提供给征信中心的客户信用记录历史(月数据)

包含了客户在征信中心的信用记录, 违约金额, 违约时间等. 以时间序列(按行)的形式进行记录.

(3) POS_CASH_balance 客户在Home Credit数据库中POS( ...

电商知识图谱

本文从需求分析和体系化构建的角度出发,阐述在电商这一特殊领域的知识图谱构建过程中,形成的一整套概念体系,还有在此过程中,通过算法、工程、产品、运营和外包团队投入大量精力,通过不断磨合逐渐完善的平台架构和审核流程。

1.背景

电商认知图谱从17年6月启动以来,通过不断从实践到体系化的摸索,逐渐形成了一套较为完善的电商数据认知体系。

在当前集团不断拓展业务边界的背景下,数据互联的需求越来越强烈,因为这是跨领域的搜索发现、导购和交互的基础,也是真正能让用户“逛起来”要具备的基础条件。但在此之前,我们需要对当前的问题做一个分析。

1.1 问题

更复杂的数据应用场景不仅是传统的电商,现在我们面临的是新零售、多语言、线上线下结合的复杂购物场景,所用到的数据也往往超出了以往的文本范围,这些数据往往都具有一些特点:

非结构化互联网的大量数据都是分散在各个来源而且基本是非结构化文本方式来表示,目前的类目体系从商品管理角度出发,做了长期而大量的工作,仍然只是覆盖了大量数据的冰山一角,这对于认知真正的用户需求当然是远远不够的。

充满噪声:不同于传统的文本分析,目前集团内的数据大部分是query、title ...