Learning to Prompt for Vision-Language Models

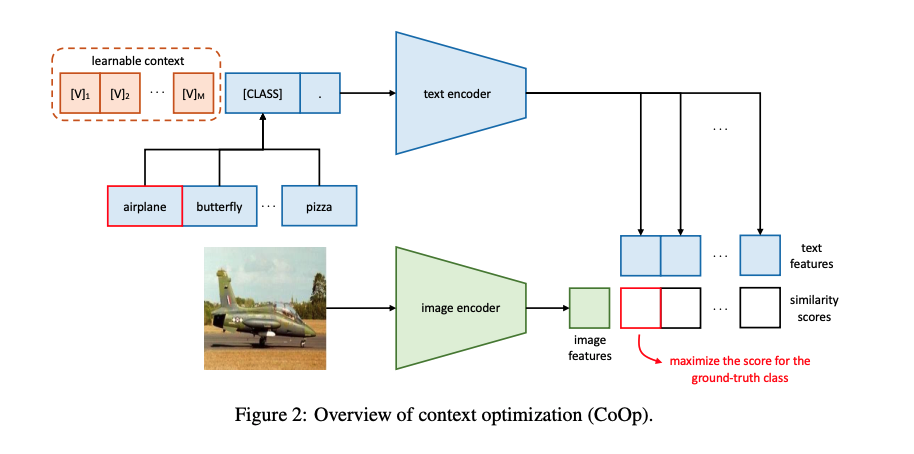

本篇博文我们主要关注prompt在视觉语言模型中的一个应用。我们知道一个好的prompt需要专业的领域知识以及大量实验进行优化,并且prompt的轻微变化可能会对性能产生巨大的影响。因此在实际应用时主要的挑战是如何对不同的下游任务构建特定的prompt。本文作者提出了一种context optimization(CoOP)的方法,通过构造soft prompt方式,即prompt参数化可学习,结合离散标签使用continuous representation建模上下文,并在保持预训练学习的参数固定的同时从数据中进行端到端学习优化,让网络学习更好的prompt。这样,与任务相关的prompt设计就可以完全自动化了。实验结果表明,CoOP在11个数据集上有效地将预训练的视觉语言模型转化为数据高效的视觉任务学习模型,只需少量样本微调就能击败手工设计的提示符,并且在使用更多样本微调时能够获得显著的性能提升。

论文地址: https://arxiv.org/abs/2109.01134

论文源码地址: https://github.com/KaiyangZhou/CoOp

方法

对于预训练 ...

(转)格局打开,带你解锁 prompt 的花式用法

今天我想要分享的是在工业实践中使用 prompt 的一些实践和心得体会。话不多说,我们直接开始。

初次关注到 prompt 是在去年GPT-3发布之后,我读到了一篇论文,It’ s Not Just Size That Matters: Small Language Models Are Also Few-Shot Learners ,了解我的小伙伴都会知道,虽然我是一个预训练语言模型的使用者,甚至生产者,但对于超大规模的语言模型,我一直持相对否定的态度,所以这篇文章的标题就相当吸引我,并且读下来之后,隐隐感觉,将文本理解任务转换为预训练的任务形式,再使用预训练语言模型,去做这个任务,这个思路简直太无懈可击了!利用它,我们可以更轻松地完成很多工作,又不必去面对例如样本类别均衡之类的数据分布上的困扰。

但当时却没有勇气直接应用起来。

到了今年,prompt 成为了一个相当火热的方向,在那篇 prompt 综述[1]出来了之后,我们知道,prompt 已经成气候了,它已经被很多工作验证是有用的了,也终于下定了决心,在我们的项目中尝试使用它,并看一下它到底有多么神奇。用过之后,不得不说,真香 ...

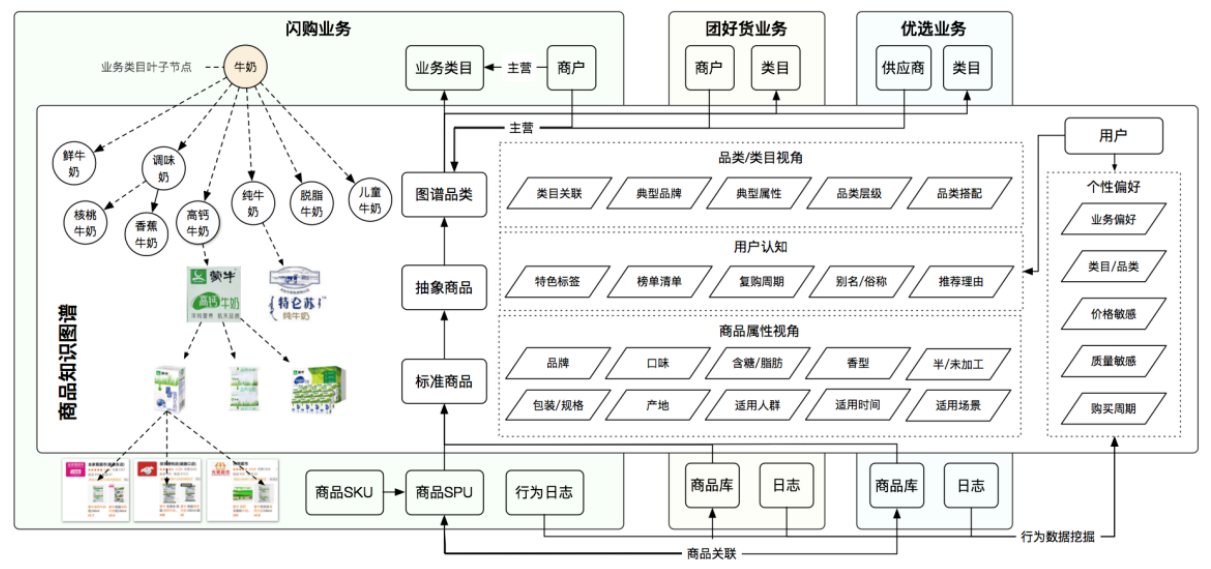

(转)美团商品知识图谱的构建及应用

在互联网新零售的大背景下,商品知识图谱作为新零售行业数字化的基石,提供了对于商品相关内容的立体化、智能化、常识化的理解,对上层业务的落地起到了至关重要的作用。相比于美团大脑中围绕商户的知识图谱而言,在新零售背景下的商品知识图谱需要应对更加分散、复杂的数据和业务场景,而这些不同的业务对于底层知识图谱都提出了各自不同的需求和挑战。美团作为互联网行业中新零售的新势力,业务上已覆盖了包括外卖、商超、生鲜、药品等在内的多个新零售领域,技术上在相关的知识图谱方面进行了深入探索。本文将对美团新零售背景下零售商品知识图谱的构建和应用进行介绍。

背景

近年来,人工智能正在快速地改变人们的生活,背后其实有两大技术驱动力:深度学习和知识图谱。我们将深度学习归纳为隐性的模型,它通常是面向某一个具体任务,比如说下围棋、识别猫、人脸识别、语音识别等等。通常而言,在很多任务上它能够取得很优秀的结果,同时它也有一些局限性,比如说它需要海量的训练数据,以及强大的计算能力,难以进行跨任务的迁移,并且不具有较好的可解释性。在另一方面,知识图谱作为显示模型,同样也是人工智能的一大技术驱动力,它能够广泛地适用于不同的任务。相比 ...

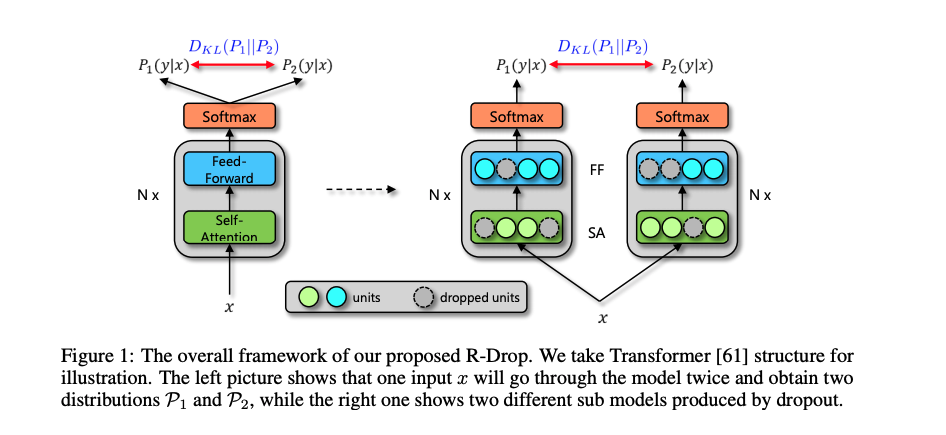

R-Drop-Regularized Dropout for Neural Networks

近年来,深度神经网络在各个领域都取得了令人瞩目的成功。在训练大规模的模型时,正则化技术是防止模型过拟合现象不可缺少的模块,同时具备提升模型的泛化(generalization)能力,其中,Dropout 是一个常见的正则化技术。本文作者在Dropout方法的基础上提出了一个正则方法R-Drop(Regularized Dropout),通过在一个batch中,每个数据样本经过两次带有 Dropout 的同一个模型,并使用 KL-divergence 约束两次的输出一致。实验结果表明,R-Drop在5个常用的包含 NLP 和 CV 的任务上(一共18个数据集)取得了不错的效果。

论文地址: https://arxiv.org/pdf/2106.14448.pdf

论文源码地址: https://github.com/dropreg/R-Drop

方法

本文作者提出的R-Drop模型结构如下所示:

具体来说,当给定训练数据D={xi,yi}(i=1)nD=\lbrace x_i,y_i \rbrace_{(i=1)}^nD={xi,yi}(i=1)n 后,对于每个训练样本 xi ...

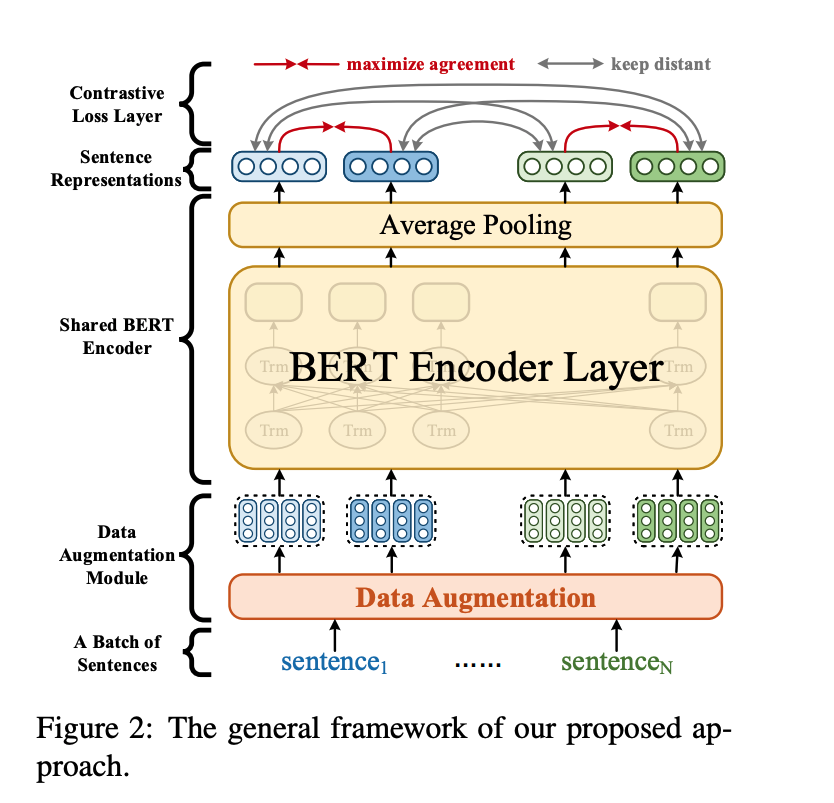

ConSERT-A Contrastive Framework for Self-Supervised Sentence Representation Transfer

尽管基于BERT的模型在诸多NLP任务中取得了不错的性能(通过有监督的Fine-tune),但其自身计算的句向量(不经过Fine-tune,而是直接通过对所有词向量求平均)往往被约束在一个很小的区域内,表现出很高的相似度(这种现象一般叫做"model Collapse"), 因而难以反映出两个句子的语义相似度。本文作者提出了一种基于对比学习的句子表示方法ConSERT (a Contrastive Framework for Self-Supervised SEntence Representation Transfer),通过在目标领域的无监督语料上微调,使模型生成的句子表示与下游任务的数据分布更加适配。实验结果表明,ConSERT在句子语义匹配任务上取得了state-of-the-art结果,并且在少样本场景下仍表现出较强的性能提升。

论文地址: https://arxiv.org/pdf/2105.11741.pdf

论文源码地址: https://github.com/yym6472/ConSERT

介绍

句向量表示学习在自然语言处理(NLP)领域占据重 ...

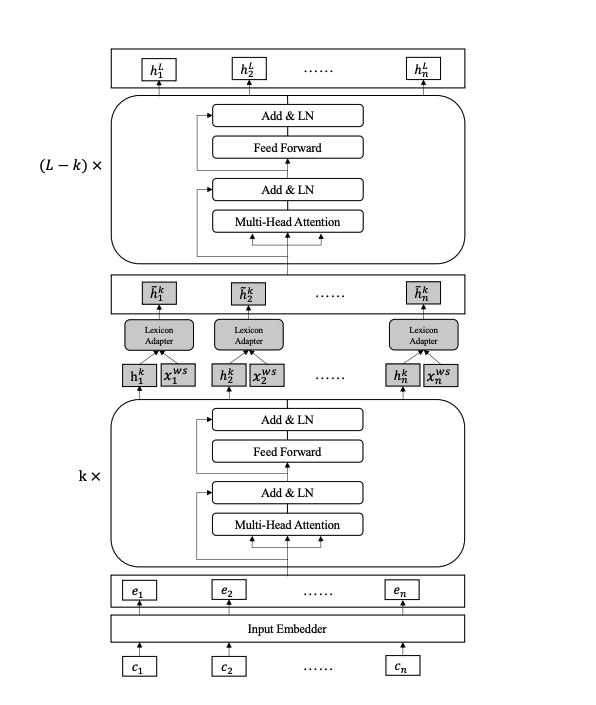

Lexicon Enhanced Chinese Sequence Labelling Using BERT Adapter

近年来,将外部词汇信息特征与预训练模型相融合是提高序列标注任务(如NER)效果的重要方法之一,比如FLAT、WC-LSTM等,但是,现有方法仅通过浅层模型表示和随机初始化的序列层融合词汇特征,并未与预训练模型如BERT进行融合。本文作者提出了用于中文序列标签的Lexicon增强BERT(LEBERT),通过一个Lexicon adapter层将外部词汇信息直接融合到BERT层中,与现有方法相比,LEBERT模型有助于在BERT的较低层进行深度词汇知识融合。实验结果表明,该模型在多个中文序列标注任务上取得了state-of-the-art结果。

论文地址: https://arxiv.org/pdf/2105.07148.pdf

论文源码地址: https://github.com/liuwei1206/LEBERT

介绍

常见一种将词汇信息与预训练模型相融合的方案是将预训练模型(如BERT)输出与词汇特征通过一个融合层(比如线性层)得到融合向量。如下图a所示:

本文作者认为该方案并没有充分利用到预训练模型的表示能力,因为外部词汇信息未融合到预训练模型之中,于是提出了另一种融合方案 ...

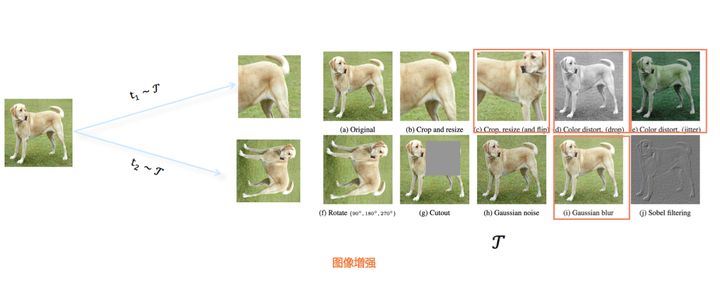

(转)对比学习(Contrastive Learning):研究进展精要

对比学习(Contrastive Learning)最近一年比较火,各路大神比如Hinton、Yann LeCun、Kaiming He及一流研究机构比如Facebook、Google、DeepMind,都投入其中并快速提出各种改进模型:Moco系列、SimCLR系列、BYOL、SwAV……,各种方法相互借鉴,又各有创新,俨然一场机器学习领域的军备竞赛。对比学习属于无监督或者自监督学习,但是目前多个模型的效果已超过了有监督模型,这样的结果很令人振奋。

我想,NLP领域的Bert模型,对于这波图像领域的对比学习热潮,是具有启发和推动作用的。我们知道,Bert预训练模型,通过MLM任务的自监督学习,充分挖掘了模型从海量无标注文本中学习通用知识的能力。而图像领域的预训练,往往是有监督的,就是用ImageNet来进行预训练,但是在下游任务中Fine-tuning的效果,跟Bert在NLP下游任务中带来的性能提升,是没法比的。

“但是,既然NLP这样做(自监督,无需标注数据)成功了,图像领域难道就不能成功吗?”我相信,追寻这个问题的答案,应该是促使很多人,从图像领域的有监督预训练,向自监督预训练 ...

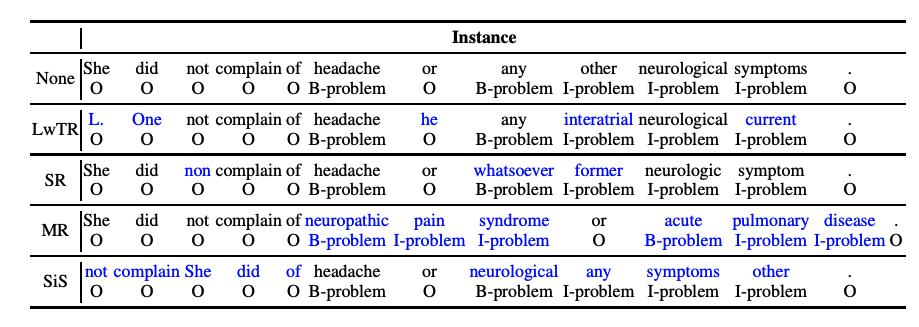

An Analysis of Simple Data Augmentation for Named Entity Recognition

现有NLP的数据增强大致有两条思路:一个是加噪,另一个是回译,均为有监督方法。加噪即为在原数据的基础上通过替换词、删除词等方式创造和原数据相类似的新数据。回译则是将原有数据翻译为其他语言再翻译回原语言,由于语言逻辑顺序等的不同,回译的方法也往往能够得到和原数据差别较大的新数据。本文借鉴sentence-level的传统数据增强方法,探究了不同的数据增强方法对NER任务的影响,发现:在低资源条件下,数据增强效果增益比较明显,而在充分数据条件下,数据增强可能会带来噪声,导致指标下降。

论文地址: https://arxiv.org/pdf/2010.11683.pdf

论文源码地址: https://github.com/abdulmajee/coling2020-data-augmentation

方法

在本文中,作者借鉴了sentence-level的传统数据增强方法,将传统的文本增强方法应用于NER任务中,并进行全面分析与对比。主要有以下4种数据增强方法(如下图所示):

Label-wise token replacement (LwTR):即相同标签的token替换,通过一个 ...

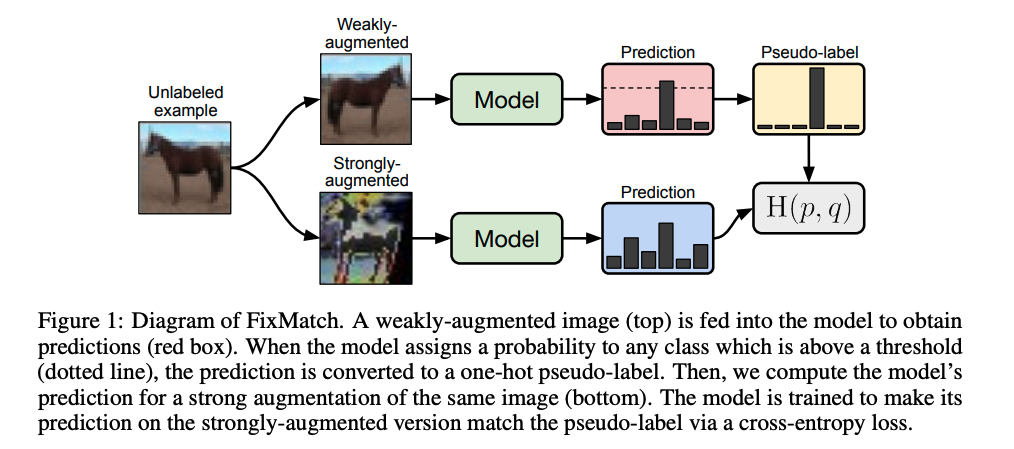

FixMatch:Simplifying Semi-Supervised Learning with Consistency and Confidence

本篇博文我们主要关注半监督学习,在实际应用环境中,获得高质量的标注数据是比较耗时和昂贵的,往往都是小部分标注数据和大量的无标注数据,除了高效利用标注数据,还需要将大量的无标注数据发挥出价值。半监督学习(Semi-supervised learning,SSL)是一种学习方法,其使用少量标注的数据和大量未标注的数据进行学习,从而得到一个高质量模型。本文作者提出一种名为FixMatch的半监督学习算法,通过对每一张没有标注的图片进行弱增强和强增强,首先对弱增强产生的数据通过模型产生伪标签,当模型的预测得分高于一定的阈值时,伪标签作为该样本标签,并与强增强数据模型预测结果进行计算损失。实验结果表明,FixMatch在众多的半监督学习方法中达到了最好的效果。仅用了250张标注数据,在CIFAR-10数据集上达到了94.93%的准确率;仅用了40张标注数据,在CIFAR-10数据集上达到了88.61%的准确率(每个标签仅4张标注数据)。

论文地址: https://arxiv.org/abs/2001.07685

论文源码地址: https://github.com/google-resear ...

StructBERT-Incorporating Languages structures into pre-training for deep language understading

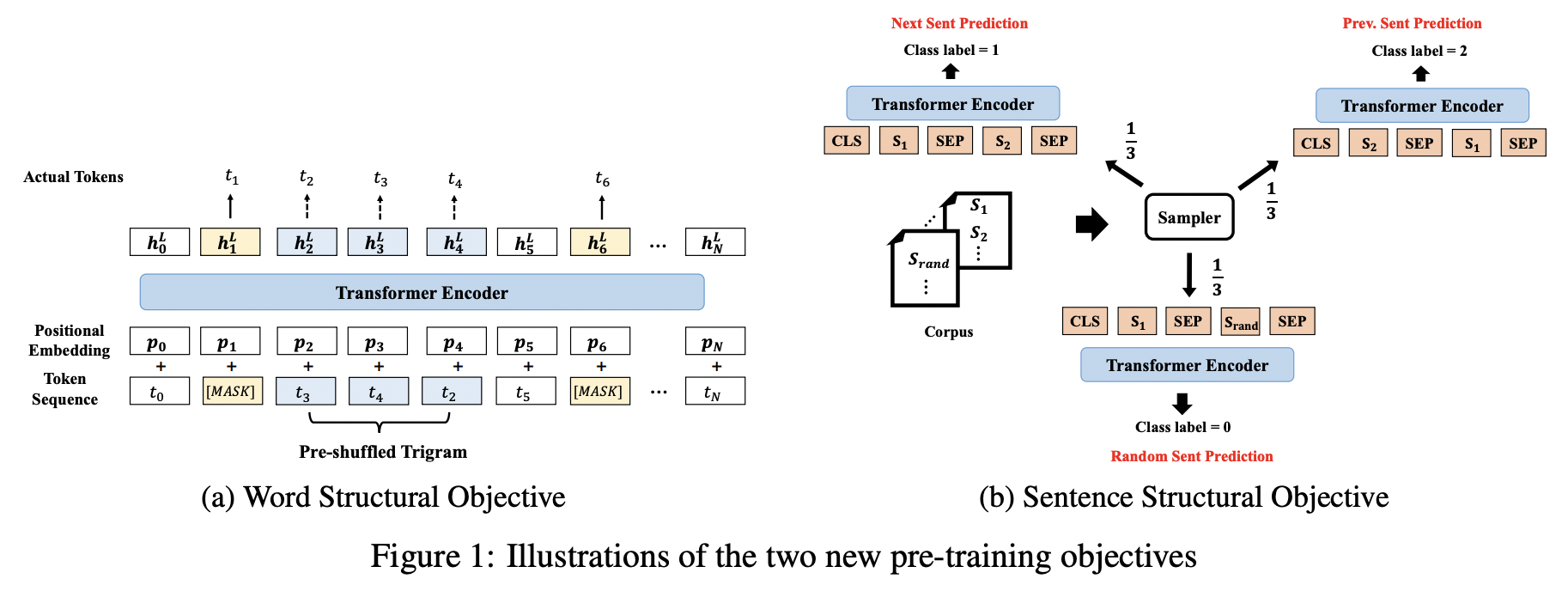

BERT的两个任务主要是MLM和NSP,虽然取得了先进的性能,但是作者认为其并未充分利用句子的语言结构。作者将语言结构信息引入到预训练任务中,提出了一种新型的上下文表示模型-StructBERT,本质上,StructBERT的模型架构和BERT一样,不同点在于新增了两个预训练目标来增强模型的预训练,即:Word Structural Objective和Sentence Structural Objective

论文地址: https://arxiv.org/pdf/1908.04577v3.pdf

论文源码地址: https://github.com/alibaba/AliceMind/tree/main/StructBERT

方法

本文作者提出的StructBERT模型结果如下所示:

具体来说,原模型还是BERT,主要在预训练任务上做了改进,主要有:WSO和SSO。

Word Structural Objective

BERT无法直接显式的对单词顺序和高阶依赖性建模。而将一句话中的单词打乱,一个好的语言模型应该能够通过重组单词顺序恢复句子的正确排列。为了能在StructBE ...