【速读】:该论文试图解决深度研究(Deep Research)智能体在长程任务中面临的三大核心问题:(1) 上下文噪声累积导致的认知过载;(2) 执行脆弱性引发的级联错误;(3) 架构僵化带来的扩展性缺失。解决方案的核心在于构建一个层次化多智能体框架,通过子目标驱动的结构化记忆机制将上下文复杂度从 降至 ,并引入 Supervisor 模块实现主动异常检测与上下文修剪,从而在 GAIA、BrowseComp、Humanity’s Last Exam 等基准上取得 SOTA 表现。

【机构】:腾讯 BAC(商业广告中心);清华大学;复旦大学

1. 背景与核心洞察 (The Core Insight)

深度研究(Deep Research)作为大语言模型向自主智能体演进的关键能力,旨在让模型能够主动发现、验证并综合来自动态真实环境的信息。OpenAI、Google、Kimi 等机构近期相继推出 Deep Research 产品,标志着这一方向已从学术研究走向工业落地。然而,现有系统普遍采用单体(Monolithic)架构,在面对需要数百步交互的长程任务时,暴露出三个根本性瓶颈。

第一,认知过载(Cognitive Overload)。传统 ReAct 范式将每轮交互的原始执行日志线性累积,导致有效信息被淹没在噪声中。当上下文长度超过一定阈值后,模型不仅难以维持原始用户意图,甚至出现 “lost-in-the-middle” 现象——有效信息被无效尝试所稀释。

第二,系统脆弱性(Systemic Fragility)。缺乏鲁棒错误检测与恢复机制的情况下,微小的工具调用失败或语义偏差可能触发级联故障,使系统陷入递归的次优循环。这在 BrowseComp 等需要与动态网页深度交互的基准中尤为致命。

第三,扩展性缺失(Lack of Extensibility)。刚性架构难以无缝集成领域特定的专用子智能体或新工具,限制了系统在复杂信息环境中的组合能力与适应性。

Yunque DeepResearch 的核心洞察在于:深度研究任务的本质是层次化的目标分解与执行,而非线性的动作序列。因此,系统架构应当显式区分战略层(全局规划)与战术层(原子执行),并通过结构化的记忆单元而非原始日志来维护历史状态。这一洞察直接催生了框架的四个核心设计原则:有效的编排系统、动态上下文管理、模块化扩展性、以及稳定性与鲁棒性保障。

2. 技术方案深度拆解 (The “How”)

2.1 整体架构

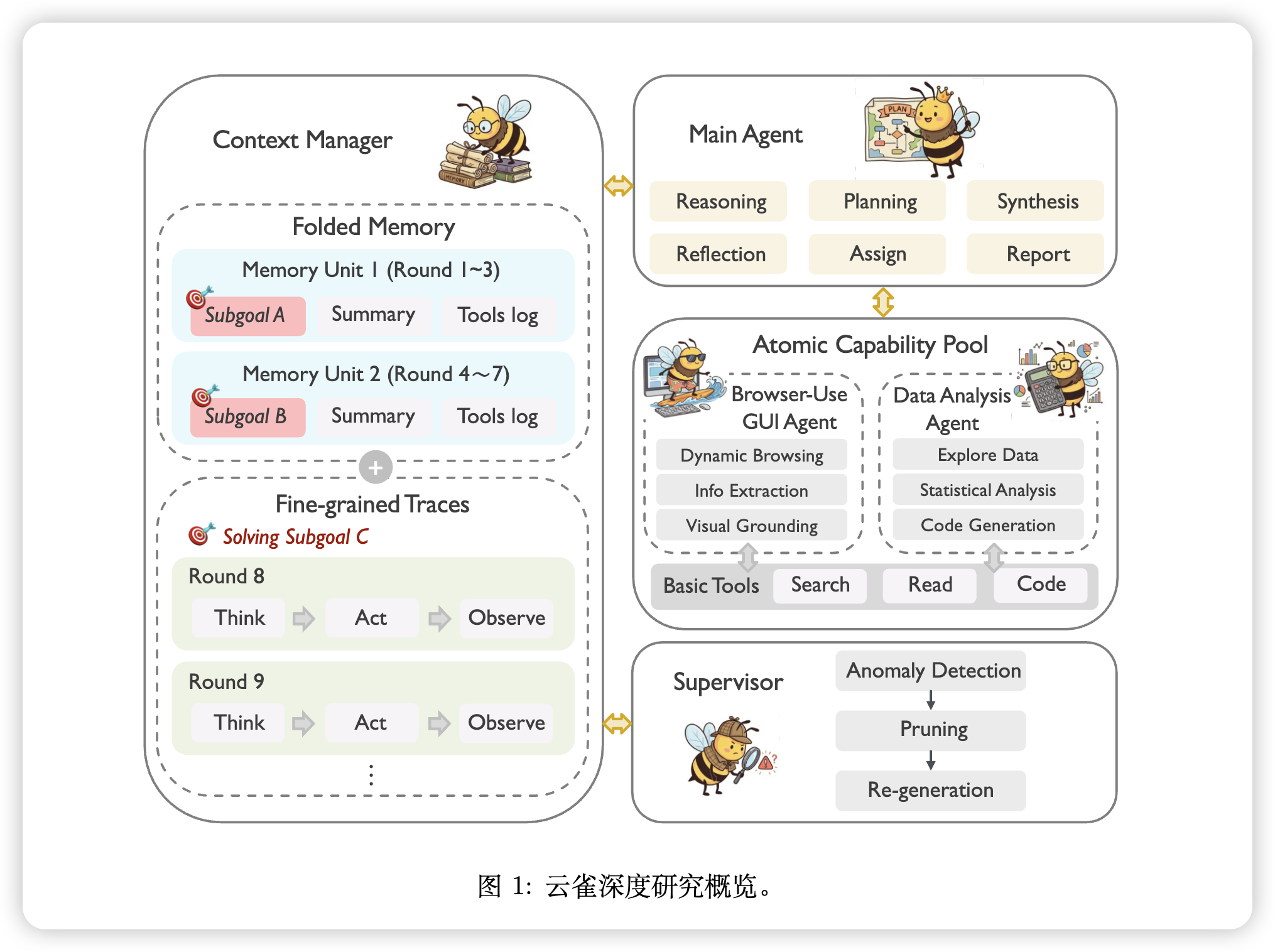

Yunque DeepResearch 采用层次化架构,将原子能力与中心推理过程显式解耦。框架由四个协作模块组成:

模块功能解析:

-

Main Agent(主智能体):系统的中央执行器,负责高层意图识别、动态规划、全局编排与结果综合。它采用交错式推理范式,根据每步反馈动态调整后续计划。

-

Context Manager(上下文管理器):支持长程任务导航的双层记忆结构,在即时操作精度与长期战略上下文之间取得平衡。

-

Atomic Capability Pool(原子能力池):容纳多样化的专用子智能体(如 Browser-Use GUI Agent 和 Data Analysis Agent)与基础工具,实现特定原子动作的执行。

-

Supervisor(监督器):通过监控执行轨迹、执行错误纠正、防止多轮交互中的级联故障来确保系统鲁棒性。

2.2 子目标驱动的结构化记忆机制

这是 Yunque DeepResearch 最具工程价值的创新。传统 ReAct 的上下文复杂度随交互轮数线性增长 ,而该机制通过将执行轨迹按语义意图划分为记忆单元,将复杂度降至子目标数量级 。

记忆单元结构

每个记忆单元定义为四元组:

其中:

- :贡献于该子目标的全局轮次索引列表

- :当前子目标的语义描述,提供短期指导

- :持久化的工具使用日志,包含工具名称、参数与执行结果

- :任务执行过程中提取的关键信息增量摘要

完整的记忆列表 构成驱动智能体向任务完成推进的宏观规划路径。

动态折叠与新增机制

引入端到端记忆模型 管理子目标间的转换。在每轮交互 ,模型处理最新主智能体响应 、动作产生的观察 以及最新记忆单元 ,输出二元指示器 和更新后的单元 :

折叠操作():当前轮次子目标与 一致, 作为最新更新的记忆单元直接替换列表末尾元素:

新增操作():当前轮次子目标与现有最新记忆单元不同, 作为新构造的记忆单元追加到列表:

自适应上下文构建

基于结构化记忆 ,系统采用动态上下文管理策略。设用户查询为 ,当前记忆单元的轮次计数为 ,上下文 可按以下两种格式交替构建:

模式一(ReAct 追加模式):当 时,智能体正在积极追求当前子目标 ,保留增量式 ReAct 格式,将最新响应 和观察 追加到 。这保留了跟踪子目标内局部依赖所需的细粒度执行轨迹。

模式二(记忆替换模式):当 时,信号表明智能体正在开始新子目标。执行压缩重置,将历史轮次记录替换为所有已完成子目标的序列化折叠记忆 。

复杂度分析:该机制将上下文复杂度从总轮次的 降至子目标数量的 。仅在子目标完成时触发压缩,在高层任务感知与低层操作细节之间取得平衡。

2.3 原子能力池:专用子智能体

Browser-Use GUI Agent

该子智能体通过 “观察-行动-反馈” 闭环完成基于网页的子任务,包括搜索、点击、滚动、输入和内容提取。与纯文本获取管道不同,它显式建模交互元素与多标签状态,在需要真实交互的场景(如分页、可折叠区域、登录弹窗、懒加载内容)中实现鲁棒信息获取。

POMDP 形式化:

将交互建模为部分可观察的序贯决策过程:

其中 为任务空间, 为动作空间, 为底层环境状态空间(对智能体不完全可观察), 为观察空间, 为状态转移函数。

观察构成:

- :解决任务所需的文本上下文(用户查询、当前子目标、关键历史发现、前序动作及返回结果)

- :从当前可见窗口提取的结构化浏览器状态(URL、标题、标签列表、滚动信息、交互元素索引及其 DOM 片段)

- :当前打开页面的截图(整页渲染)

参数化离散动作:

每个浏览器操作表示为参数化动作:

其中 指定动作类型(web_search、pdf_to_markdown、go_to_url、click_element、input_text、scroll_down/up、extract_content、open/switch/close_tab、terminate), 包含结构化参数。

关键工程细节:截图 仅作为当前步的临时多模态输入提供,不序列化到文本上下文历史中,防止长程交互中的上下文爆炸。

Data Analysis Agent

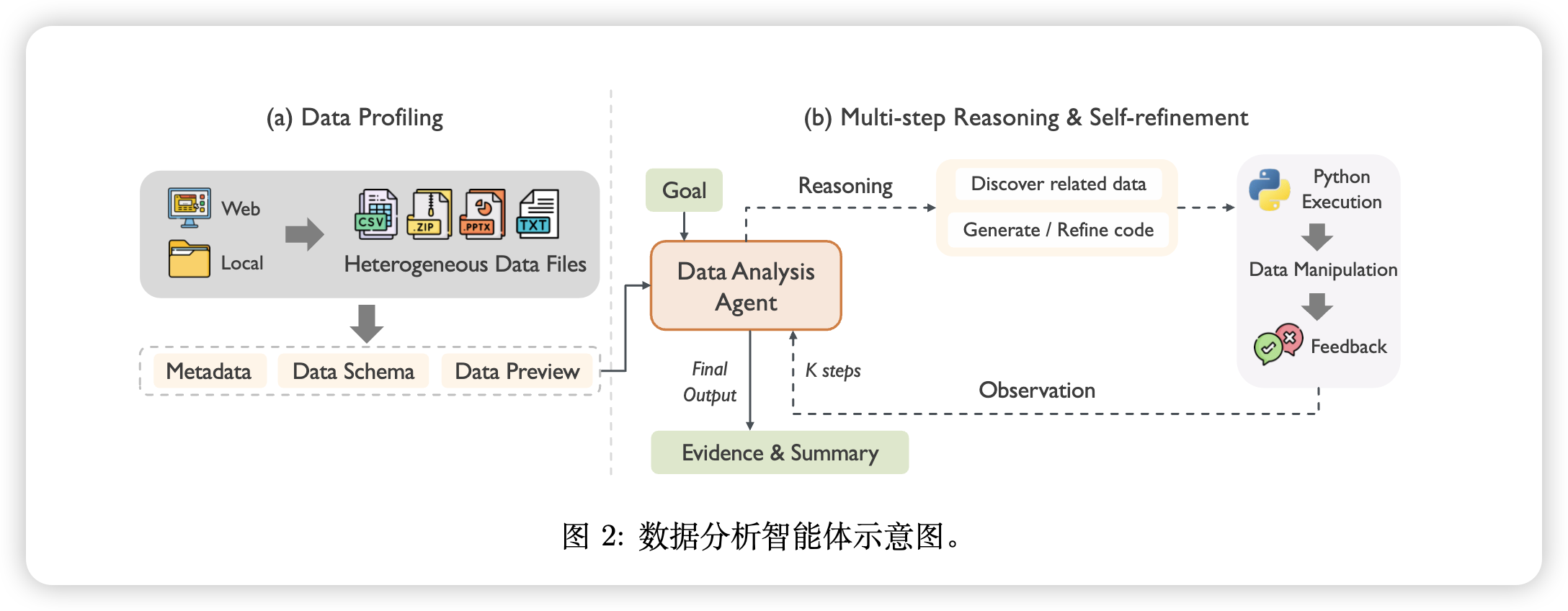

该子智能体自动化复杂数据任务,通过多步推理生成可执行代码。工作流程分为两个阶段:

阶段一:数据画像(Data Profiling)

处理来自网页或本地存储的异构数据文件,处理包括结构化数据、非结构化文本和压缩档案在内的多种格式。使用路由机制调用适当工具(如 Pandas 处理表格数据、专用解析器处理文档),提取包含以下三要素的结构化描述:

- 元数据:文件名、大小、类型

- 数据模式:维度、列名

- 数据预览:内容片段或完整内容、统计摘要

阶段二:多步推理与自精炼

基于精心编制的数据画像,智能体进入由用户目标驱动的迭代推理与精炼循环:

- 推理与代码生成:基于画像上下文和当前目标,推理确认文件相关性,发现相关数据段,生成可执行的 Python 脚本

- 执行与反馈:在安全的沙箱中执行生成的代码,捕获执行输出或错误信息作为反馈

- 观察与自精炼:评估反馈;若发生错误,触发自精炼以修正代码;成功观察则指导下一步推理

2.4 Supervisor:自适应中断与自纠正机制

在复杂长程推理任务中,智能体常陷入认知惯性——尽管执行失败仍坚持无效行为。常见症状包括语法错误(如格式错误的工具调用)和语义停滞(如重复输出或递归循环)。

Supervisor 模块配备自适应中断与自纠正机制,与可能干扰有效推理链的刚性反思调度不同,它持续评估智能体轨迹中的异常。检测到失败或停滞信号时,触发抢占式中断,强制将智能体从自动行动模式转换到高层反思模式。在此状态下执行三阶段恢复协议:

- 异常诊断:提示智能体批判性分析执行历史, pinpoint 失败根本原因

- 轨迹修剪:为防止上下文污染,系统显式从上下文窗口中修剪近期无效交互痕迹,确保智能体未来决策不受失败尝试偏见影响

- 重新生成:智能体综合替代输出(如修订计划或修正结论),有效打破局部循环,引导工作流回到有效解决方案路径

2.5 与 Baseline 的本质差异

| 维度 | 传统 ReAct Agent | Yunque DeepResearch |

|---|---|---|

| 架构 | 单体 | 层次化(Main Agent + 子智能体) |

| 记忆 | 线性原始日志 | 子目标驱动的结构化记忆单元 |

| 上下文复杂度 | , | |

| 容错 | 被动失败 | Supervisor 主动异常检测与恢复 |

| 扩展性 | 刚性 | 原子能力池支持动态注册新能力 |

3. 验证与实验分析 (Evidence & Analysis)

3.1 实验设置

- 超参数:temperature = 1.0,top-p = 0.95

- 时间限制:每题 1.5 小时

- 工具调用上限:75 次

- 实验时间:2026 年 1 月

- 基座模型:消融实验统一使用 Gemini-3-pro

- 专用子智能体最大步数:10 步

评测基准:

- GAIA:通用 AI 助手能力评测

- BrowseComp / BrowseComp-ZH:浏览与信息综合能力评测

- Humanity’s Last Exam:人类最后考试(高难度知识推理)

主要指标:Pass@N(N 次独立执行中至少出现一次正确解的概率),默认报告 Pass@1

3.2 主实验结果

| 系统类型 | 模型/框架 | BrowseComp | BrowseComp-ZH | GAIA | Humanity’s Last Exam |

|---|---|---|---|---|---|

| 通用 LLM + ReAct | Gemini 3 Pro | 52.5 | 67.1 | 73.8 | 45.8 |

| 开源智能体框架 | MiroFlow | 33.2 | 47.1 | 82.4 | 27.2 |

| 闭源智能体框架 | OpenAI DeepResearch | 51.5 | 42.9 | 67.4 | 26.6 |

| Yunque DeepResearch | Gemini | 62.5 | 75.9 | 78.6 | 51.7 |

关键发现:

-

框架显著提升基座模型能力:相比标准 ReAct 基线,Yunque DeepResearch 将 Gemini 3 Pro 在 BrowseComp 上提升 +10.0,在 GAIA 上提升 +4.8,证明智能体设计有效释放了底层 LLM 的潜力。

-

在开放域研究中具有卓越竞争力:在 BrowseComp、BrowseComp-ZH 和 Humanity’s Last Exam 上均取得 SOTA,在 GAIA 上获得第二(仅次于专门优化的 MiroFlow)。

3.3 跨基座模型泛化性

为验证性能提升源于框架设计而非仅依赖底层模型能力,评估了 Yunque DeepResearch 在不同基座模型上的表现:

| 模型 | 模式 | GAIA | BrowseComp-ZH | BrowseComp | HLE |

|---|---|---|---|---|---|

| DeepSeek-V3.2 | ReAct | 70.9 | 65.0 | 51.4 | 40.8 |

| DeepSeek-V3.2 | Ours | 76.7 | 75.1 | 59.5 | 46.6 |

| 提升 | +5.8 | +10.1 | +8.1 | +5.8 | |

| Kimi K2 Thinking | ReAct | 69.9 | 62.3 | – | 44.9 |

| Kimi K2 Thinking | Ours | 74.8 | 61.9 | – | – |

| 提升 | +4.9 | -0.4 | – | – | |

| Gemini 3 Pro | ReAct | 73.8 | 67.1 | 52.5 | 45.8 |

| Gemini 3 Pro | Ours | 78.6 | 75.9 | 62.5 | 51.7 |

| 提升 | +4.8 | +8.8 | +10.0 | +5.9 |

DeepSeek-V3.2 和 Gemini 3 Pro 在所有基准上均表现出稳健提升,峰值增益分别为 +10.1(BrowseComp-ZH)和 +10.0(BrowseComp)。Kimi K2 Thinking 在 BrowseComp-ZH 上略有波动,但在 GAIA 上获得 +4.9 的实质性改进。

3.4 消融实验:模块化设计的有效性

| 配置 | GAIA | BrowseComp | BrowseComp-ZH | HLE |

|---|---|---|---|---|

| Yunque DeepResearch | 78.6 | 62.5 | 75.9 | 51.7 |

| w/o Memory | 77.7 (-0.9) | 52.1 (-10.4) | 68.5 (-7.4) | 51.7 (0) |

| w/o Supervisor | 69.9 (-8.7) | 58.1 (-4.4) | 65.4 (-10.5) | 50.5 (-1.2) |

| w/o Browser-Use GUI Agent | 71.8 (-6.8) | 61.7 (-0.8) | – | – |

| w/o Data Analysis Agent | 75.7 (-2.9) | – | – | 51.7 (0) |

关键归因分析:

-

Memory 模块的关键作用:移除记忆模块导致浏览任务性能急剧下降(BrowseComp -10.4,BrowseComp-ZH -7.4)。这些基准需要长程信息获取与多跳推理,此下降凸显了记忆机制在缓解网页浏览固有高噪声比方面的关键作用。标准 ReAct 范式常遭受上下文溢出和 “lost-in-the-middle” 现象,而 Yunque 的记忆管理通过子目标将智能体轨迹划分为语义连贯单元,保留了信息密度。

-

Supervisor 的保障价值:Supervisor 作为复杂任务执行的关键保障,其移除导致 GAIA (-8.7)、BrowseComp-ZH (-10.5)、BrowseComp (-4.4) 和 HLE (-1.2) 的显著下降。该模块通过主动监控失败信号、拦截错误并清除上下文窗口中的无效交互痕迹,防止 “错误累积”,确保智能体推理过程不受污染。

-

专用智能体的必要性:GAIA 基准的消融显示,移除 Browser-Use GUI Agent 和 Data Analysis Agent 分别导致 -6.8 和 -2.9 的性能回退。这验证了鲁棒的 “通用” 辅助能力源于专用原子能力的编排这一假设。

4. 局限性与落地思考 (Critical Review)

4.1 复现门槛与工程约束

基座模型依赖:论文明确指出,选择代表性基座模型的依据是其强大的指令遵循能力,因为精确的工具调用是框架运行的前提。这意味着并非所有开源模型都能直接适配该框架——若底层模型缺乏可靠的函数调用能力,整个系统的稳定性将大打折扣。

计算资源需求:虽然论文未提供具体的 token 消耗与推理延迟系统分析,但基于框架设计可推断:

- 每轮交互涉及记忆模型 的调用,增加额外推理开销

- 专用子智能体(尤其是 Browser-Use GUI Agent)的多步决策循环带来显著延迟

- 75 次工具调用上限与 1.5 小时时间限制暗示了实际部署的计算成本

隐含的 “Magic Numbers”:

- 专用子智能体的最大步数设置为 10 步——该数值的来源未在论文中解释

- Temperature = 1.0 与 top-p = 0.95 的组合——在长程任务中,较高的 temperature 可能增加方差,作者未讨论该权衡

4.2 潜在短板

评估覆盖的局限性:消融实验主要基于 GAIA 基准,而 GAIA 虽作为通用能力的稳健测试平台,可能无法完全捕捉专用领域的细微差别。Browser-Use GUI Agent 和 Data Analysis Agent 在更专业的场景(如 OSWorld 的复杂交互环境导航、DSBench 的综合数据分析)中的表现尚未验证。

Supervisor 的误触发风险:虽然 Supervisor 的设计旨在检测异常并恢复,但论文未讨论误触发(False Positive)的情况——在哪些边界条件下,正常的探索性行为可能被误判为 “异常” 而触发不必要的中断?这可能影响智能体的创造性问题解决能力。

记忆压缩的信息损失:尽管子目标驱动的记忆机制在统计上有效,但理论上任何压缩都伴随信息损失。对于需要精细回溯特定执行步骤的调试场景,折叠后的记忆单元可能丢失关键的中间状态信息。

4.3 落地启示

可借鉴的设计模式:

-

子目标作为压缩单元:在长程交互系统中,以语义意图(子目标)而非原始时间步作为记忆管理的基本单元,是平衡信息密度与完整性的有效策略。

-

显式分层 vs. 隐式端到端:Yunque 的设计验证了显式架构分层(Main Agent / 子智能体 / 工具)相比端到端训练的可解释性与可维护性优势,特别适合需要人类审计的 production 环境。

-

主动容错优于被动恢复:Supervisor 的主动异常检测模式相比传统的 “失败-重试” 机制更能防止上下文污染,这一思路可推广至其他长程交互系统。

待澄清疑点(需源代码验证):

-

记忆模型 的具体实现:是独立的 LLM 调用还是与主智能体共享?其 prompt 设计如何确保子目标边界检测的准确性?

-

Browser-Use GUI Agent 的视觉编码方案:截图 的分辨率、编码方式、是否经过裁剪或压缩?这些细节直接影响视觉理解精度。

-

轨迹修剪的具体策略:Supervisor 清除 “无效交互痕迹” 时,如何界定 “无效”?是基于规则还是模型判断?清除范围是固定窗口还是动态确定?

5. 总结与启示 (The Verdict)

对研发的启示

Yunque DeepResearch 代表了从 “单体智能体” 向 “层次化多智能体系统” 演进的重要实践。其核心贡献不在于提出了全新的算法,而在于将工程架构设计本身作为提升系统能力的关键杠杆。以下几点值得后续研究与工程实践借鉴:

-

架构即能力:在 LLM 能力边界相对固定的前提下,通过精巧的系统架构设计(层次化编排、结构化记忆、主动容错)可以显著释放模型潜力。

-

语义压缩优于无损存储:在长上下文场景中,以语义单元(子目标)为粒度的有损压缩,相比原始日志的无损存储,在信息密度与模型推理效率之间取得了更优平衡。

-

专用化与通用性的统一:通过原子能力池将专用子智能体(GUI Agent、Data Analysis Agent)与通用主智能体解耦,既保证了系统的通用性,又通过专用模块实现了领域精化。

待澄清疑点

- 记忆模型的训练细节(如有)或 prompt 工程策略

- 视觉输入的具体处理流程与分辨率设置

- Supervisor 的异常检测规则或模型架构

- 工具调用失败时的重试策略与退避机制

- 多模态信息(截图)与文本上下文的融合方式

最终评价

Yunque DeepResearch 是一个工程导向、架构驱动的深度研究框架。它在 BrowseComp、BrowseComp-ZH 和 Humanity’s Last Exam 上取得的 SOTA 结果,以及跨基座模型的稳定提升,证明了层次化多智能体架构与结构化记忆机制的有效性。开源实现为社区提供了可复现的基础,但在生产环境部署时,需针对具体的基座模型能力、延迟要求与成本约束进行细致调优。该框架最适合的应用场景是需要深度信息综合、可容忍分钟级响应延迟的研究型任务,而非实时交互场景。